“La inteligencia artificial necesita perfiles de humanidades”

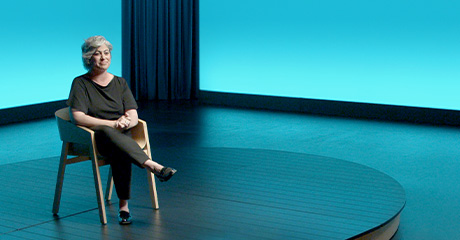

Cristina Aranda

“La inteligencia artificial necesita perfiles de humanidades”

Cristina Aranda

Filóloga experta en IA

Creando oportunidades

Cómo la inteligencia artificial está cambiando nuestro mundo

Cristina Aranda Filóloga experta en IA

Cristina Aranda

¿Qué es la inteligencia artificial y cómo funciona? ¿Nos quitarán las máquinas el trabajo? ¿Qué papel jugará la ética en el futuro de la tecnología? ¿Cómo se puede aplicar la inteligencia artificial a la educación? ¿Por qué la inteligencia artificial necesita perfiles de humanidades? Todas estas preguntas, y muchas más, las responde Cristina Aranda, filóloga experta en inteligencia artificial. Según afirma: “La inteligencia artificial no te va a quitar el trabajo, pero sí lo hará una persona que entienda cómo funciona la inteligencia artificial”. Y añade: “La inteligencia artificial está en nuestro día a día, depende de nosotros cómo utilizarla de forma positiva en todos los ámbitos, como el de la educación”.

Cristina Aranda es doctora en Lingüística Teórica y Aplicada por la Universidad Autónoma de Madrid y el Instituto Universitario de Investigación Ortega y Gasset. Se licenció en Filología Hispánica en la Universidad Autónoma de Madrid. ¿Y qué hace una lingüista en el mundo de la tecnología más avanzada? Su trabajo se centra en el llamado “Procesamiento del lenguaje natural”, que se basa en hacer entender a las máquinas “nuestro maravilloso, complejo y bello sistema de comunicación: el lenguaje humano”, explica. También es cofundadora y líder de ‘MujeresTech’, una entidad sin ánimo de lucro que promueve la presencia de mujeres en el ámbito digital; y cofundadora de Big Onion, un equipo de solucionadores de tecnología disruptiva (Data, Inteligencia Artificial y Blockchain, entre otras). Es especialista en soluciones tecnológicas aplicadas de Lingüística, innovación y transformación cultural de empresas.

Transcripción

Oye, solamente juega la inteligencia artificial… La entrenamos para jugar al ajedrez. ¿Sabrá jugar al guiñote? No, sabe jugar solo al ajedrez. Si la hemos entrenado para leer o extraer la información de la factura, ¿sabrá luego cantarte una chirigota? No, porque la hemos entrenado solamente para extraer la información de una factura. Eso es la inteligencia artificial estrecha. La siguiente inteligencia artificial es la que se llama «inteligencia artificial general». Se procesa de forma multimodal. No sé si habéis visto la película «Her», donde un chaval se compra una inteligencia artificial multidispositivo y se acaba enamorando de esa inteligencia artificial. No voy a hacer «spoiler», pero es muy similar. Esa conversación es natural, espontánea, etc. Es igual. Y luego está lo que se llama la «superinteligencia», que es con lo que juegan las series, los titulares de prensa… «Los robots asesinos», ¿no? Pero yo siempre digo que aquí: «Tranquilicémonos todas y todos, porque nunca va a superar a la estupidez humana». O sea, eso es ilimitado. Eso es ilimitado. Entonces yo os pregunto: ¿en dónde creéis que está hoy en día la inteligencia artificial: estrecha, general o superinteligencia? Estamos entre la estrecha y general. Porque general, vemos estas soluciones… Como dice Yejin Choi en una maravillosa charla TEDx, estas inteligencias son increíblemente inteligentes pero asombrosamente tontas. Les falta muchísimo porque no llegan a nuestro nivel de cognición. Pensad el ser humano la capacidad asociativa que tiene, la capacidad de las dislocaciones semánticas, de captar la ironía, la metáfora… Sé que hay personas que… Pero la capacidad de ironía, semántica… Luego, el conocimiento del mundo.

Todo esto, que tenemos de forma tan brillante las personas y que lo hemos adquirido poco a poco, no lo tienen las máquinas a día de hoy.

Y el área del procesamiento del lenguaje natural es en la que entrenamos a las máquinas para que entiendan nuestro increíble, complejo, asombroso, sistema de comunicación que es el lenguaje natural. Ahora bien, ¿dónde está el reto? Porque las máquinas hablan en «techiano», hablan en ceros y unos. ¿Tú puedes querer en ceros y unos? ¿Puedes decir «Yo te quiero un cero coma…»? Ahí empiezan muchas cosas. ¿Por qué? Porque los datos son datos no estructurados de naturaleza lingüística. Entonces, si nosotros tenemos que trabajar con eso… Hemos dicho que las máquinas hablan en ceros y unos, y solamente hablan en un formato que se llama «texto». Las máquinas no… Aunque yo les hable, hay un «software» detrás, unos programas que pasan la voz a texto. Antes hemos dicho la visión. Si trabajo con un JPG, con imágenes, voy a utilizar unas herramientas que lo pasan a texto, con lo cual la riqueza de la comunicación no verbal… Imagínate que yo te hago… Eso está en texto, eso la máquina no lo interpreta, es ceros y unos. O la voz, el tono de voz, que es muy relevante en la comunicación humana. Incluso el silencio, ¿no? Eso lo pasamos a ceros y unos y ahí ya estamos quitando un poquito, un poquito bastante, de información, pero lo tenemos que pasar a ceros y unos, que es estructurar la información. Entonces, se utilizan herramientas, redes neuronales, sistemas complejos, para vectorizar la información. ¿Qué hacíais vosotras y vosotros, cuando hacíais los exámenes de lengua, comentarios de texto, cuando os daban un texto? ¿Qué hacíais lo primero de todo?

Venga. Leerlo, ¿y luego qué hacíais? Una vez después de leerlo, ¿qué hacíais? Subrayar, extraer determinados elementos. Pues esto es lo que hacemos también. Es lo que se llaman «tokens». Seguimos un determinado proceso de entrenamiento a la máquina. El entrenamiento del lenguaje tiene que ser muy supervisado, muy supervisado. Que me podréis decir: «Pues yo todavía utilizo una herramienta generativa a la que le pongo palabricas…», un «prompt» que se llama, «…y me da». Sí, pero si tenemos que trabajar en determinados entornos… Pensad en farma, salud, o incluso videojuegos, donde tienen que pasar toda la información del videojuego y adscribirla a determinados países y no pueden meter la pata porque es un impacto muy económico y reputacional, tienen que traducirlo muy bien y tienen que supervisar que eso esté muy bien, el lenguaje, ¿no? Imaginaos en detección del fraude. Si estamos trabajando con detección de fraude, no me puedo equivocar, porque… Hay un término que se utiliza mucho en inteligencia artificial, que es «accuracy», que es el ratio, el porcentaje de acierto. Entonces, el porcentaje de acierto en el lenguaje hay que entrenarlo de forma supervisada. ¿Por qué? Porque lo que nos diferencia… En su maravilloso discurso, Nuria Oliver, en su acceso como académica de la Real Academia de la Ingeniería Española, que os recomiendo, que lo deberíais leer, y es «Inteligncia Artificial: Ficción, realidad y… sueños», ella expuso cuáles son las diferencias entre la inteligencia artificial e inteligencia humana. Bueno, pues estábamos varias lingüistas en la sala, nos miramos, nos agarramos y dijimos: «¡Las lingüistas y los lingüistas vamos a salvar a la humanidad!».

¿Por qué? Porque el primer punto que ella señalaba era la semántica y los sistemas de procesamiento del lenguaje natural. Luego también señalaba… ¿Os acordáis de las dubitativas, las desiderativas, las causativas? La capacidad de pronta asociación de un concepto con el conocimiento del mundo. Eso las máquinas no lo tienen. Las máquinas son muy tontas, son loros, son loritos. Extraen patrones, pero no tienen la capacidad, la genialidad, que tenemos los seres humanos, los hablantes, para rápidamente crear redes léxico-semánticas o adquirir, por ejemplo, las palabras nuevas. Entonces, la rama de la inteligencia artificial, o una de las ramas, que más potencial tiene, y que ya lo veíamos venir las lingüistas, es esta, la del procesamiento del lenguaje natural. ¿Y los lingüistas qué podemos hacer? Ayudar a las máquinas a entender nuestro sistema complejo. Porque ya os he dicho que, una vez que ya estructuramos estos datos, lo que haríamos es ya empezar a utilizar lo que se llaman «sistemas expertos». Un sistema experto puede ser una ontología. Una ontología es… Sé que lo sabéis, pero vamos a repasar, ¿eh? ¿Qué son las ontologías? Nosotros el mundo lo clasificamos de forma conceptual a través de conceptos. ¿Y dónde tenemos el glosario de las palabras? En el diccionario. Pues oye, ahí están las palabras alojadas, pero no hay relación entre unas y otras. Luego estarían las «tags», las etiquetas. No sé si habéis trabajado con determinados formatos… Es una forma de categorizar las cosas. No hay ninguna relación entre las palabras, pero sí que están categorizadas. Y el siguiente nivel ya serían los tesauros, donde ya tienen relación léxico-semántica esas palabras. Vale, pero esas relaciones son de sinonimia, antonimia…

Y el siguiente nivel ya serían esos «thesaurus» inteligentes que se llaman «ontologías». Y entonces en una ontología estaría un usuario que tiene determinados atributos y tiene determinadas funciones y que hace cosas, con lo cual la máquina va mucho más rápido en procesamiento. Ya lee el usuario, pero está viendo toda la red de capacidades que puede hacer ese usuario. Y ahí entrenamos a la máquina. El procesamiento del lenguaje natural sirve para esto, para desambiguar, que es el gran reto que tenemos. Porque, imaginaos, entre los humanos nos cuesta entendernos muchas veces… Imaginaos que la máquina entienda nuestro sistema tan complejo, que es el lenguaje.

Igual no. Igual esta herramienta me permite ahora… Igual el contenido, el objeto de estudio, hay que adquirirlo de formas diferentes. Entonces, el profesorado tendrá que ir guiando, conduciendo, al alumnado en ese descubrimiento, generando esa ansia por conocer, y el alumnado tendrá que utilizar las herramientas que va a tener que utilizar el día de mañana en cualquier trabajo. Entonces, para mí aquí hay que… Siempre, en todo este momento, cuando implica que tengo que cambiar… Esto es como el momento de las crisálidas, el momento en que las orugas pasan a mariposas. Exige un esfuerzo, pero aquí el esfuerzo es más por parte de la comunidad educativa. El conocer estas herramientas. Estas herramientas me pueden dar un potencial maravilloso y tengo que saberlo integrar en mi día a día. Por ejemplo, puedo utilizar estas herramientas generativas de producción lingüística para generar «fakes», a ver si mis alumnos y alumnas detectan qué está hecho por una inteligencia artificial y qué no, porque es muy enlatado. El estilo es muy enlatado. O, por ejemplo: «Genérame esto y destaca lo que quieras, determinado…». «Introduce un “prompt”, mándale una instrucción a la maquinita y, ahora, en el texto que has extraído, señálame los sustantivos, los adjetivos…». Y tenemos millones de aplicaciones. Incluso para ayudar al propio profesorado a plantear la clase desde otro punto de vista y agilizar todo esto.

Es muy complejo que estas máquinas, que sí que están generando de forma audiovisual… Lo estamos viendo de diferentes formas generativas. O bien crea imágenes, audio, música, etc. Y nos puede parecer creativo, pero esto es como lo de las inteligencias artificiales, que nos puede sorprender en medida de la capacidad de la inteligencia del usuario. Si tú te crees… Claro, haces así y dices: «Hala…». Como cuando escribimos… Tú lo podías redactar perfectamente. Lo que pasa es que eres un ser vago o vaga y estás utilizando esta herramienta como el Rincón del Vago. Entre el Rincón del Vago… Y, vamos… Estas herramientas nos potencian. Quienes trabajan en este ámbito de la inteligencia artificial y la creatividad… Por ejemplo, Estado Latente, que trabajan codo con codo con Silicon Valley, ayudando a desarrollar y mejorar estas técnicas, siempre dicen que la creatividad es inherentemente humana. Ahora bien, estas son herramientas que me van a permitir trabajar de forma más eficiente. Una dupla, lo llaman «duplas creativas», pero no nos olvidemos de que con todas estas herramientas generativas tiene que trabajar la persona e introducir la instrucción. O sea que, en mi cerebro, en mi creatividad, yo he ideado un mundo mágico de color, de unicornios, como quieras, y he introducido ese «input», ese «prompt», para hacer que la máquina genere toda esa creatividad. Luego, ¿quién tiene la creatividad: la máquina o las personas?

El que yo diga: «Vale, yo he recibido esta información. ¿Pero de dónde viene la fuente? ¿Por qué me ha llegado así, tan rapidito y tan bien?». El cuestionarme que no toda la información es verdadera y también contrastar estas fuentes. Y es una misión que ya es netamente humana, que tenemos que supervisarlo con esta herramienta, que es simplemente la reflexión y el cuestionarse las cosas.

Muy importante incorporar esa ética, esa regulación, en las primeras fases del diseño y el diseño. Todos habremos utilizado alguna herramienta, no voy a decir el nombre, donde es tedioso utilizarlo, vuelves para atrás, al final tienes que dejar ese proceso de compra que es agónico… Y muchas más cosas. El diseño.Yy os podría mencionar muchas más cuestiones donde… La psicología. ¿Dónde va a apretar el botón o cómo va a usar…? O si vamos a utilizar… Fijaos, el tono de voz en un asistente virtual: ¿qué voy a utilizar, masculino o femenino, una voz femenina? «No, es que es de cuidados». Ya, pero ahí están los estereotipos. Y, si atiendes una urgencia en la carretera, ¿un hombre? ¿Las mujeres no sabemos cambiar las ruedas? ¿No? Ahí hay muchas… De hecho, hay un maravilloso libro sobre la personalidad de los asistentes virtuales. Muchas cuestiones, que aborda la inteligencia artificial y que necesitan perfiles de humanidades. Pero, claro, es que va muy rápido todo esto. Y ahí necesitamos que estos perfiles de humanidades seamos autodidactas, porque sabemos que en la formación reglada no tenemos esto. Es muy complejo que haya estas formaciones híbridas, tenemos las formaciones por silos. «Yo soy de Matemáticas. Yo, de Ingeniería. Yo, de Filología Clásica». ¿Y por qué no empezamos a generar esta convivencia en los planes de estudio? Pero como no hay convivencia, pues te va a tocar, como hice yo, descubrir paso a paso. Ir formándome. Y todos los perfiles de humanidades somos necesarios. François Chollet, que es un experto de Google que generó una librería que se llama Keras, que he hecho eso ha dado… La gente que sabe de esta tecnología sabe lo que es TensorFlow, que ha ayudado mucho a ayudar a las máquinas a entrenarse.

Bueno, pues él decía, fíjate, en un tuit de 2017: «Antes me preocupaba que la gente no supiera de matemáticas. Ahora, lo que realmente me preocupa es que la gente no sepa de humanidades». Y a la inversa, necesitamos esa convivencia de ambos conocimientos. Y aquí se requiere humildad. Se requiere humildad porque también hay que hackear estereotipos en cuanto al conocimiento. José Antonio Marina, en su maravilloso libro «La inteligencia fracasada» habla de esto. Que normalmente, por estereotipos, los más inteligentes… Ingeniería. «¡Hizo Ingeniería año a año!». Y la gente hace… «¡Hizo Filología año a año!». «Pues vale». Por eso es necesario no ser nadie más que nadie. La cooperación. De hecho, es un principio de la inteligencia artificial. La beneficencia. Hacer el bien. La de no maleficencia. De que ese uso no sea para cosas y casos que estamos viendo. Y el principio de la cooperación. Necesitamos cooperar diferentes perfiles y hacer equipos diversos.

Gladys West, una señora afroamericana. Ella genera el GPS. Y muchas, muchas… El eBook. Ángela Ruiz. De hecho, los premios nacionales de España de informática llevan su nombre. Ángela Ruiz, una maestra de León que creó una enciclopedia automática y la patentó gracias a su marido, porque en aquella época el marido tenía que autorizar que esa patente se hacía. Pero vayámonos a nada, a ayer. ¿A que nos suena supergaláctico, o supercomputacional, el reconocimiento de la córnea? Pues lo desarrolló Celia Sánchez, una catedrática de oftalmología, y lo desarrolló, lo patentó, ganó una patente y ganó un premio internacional de inventora. Y el año pasado la gran Elena García Armada, con su exoesqueleto, permite a niños en silla de ruedas, a niños y a niñas, que puedan andar y desarrollar su musculatura. Y podría seguir y seguir. El gran drama es que la historia está hecha por hombres blancos, judeocristianos, heterosexuales y sin discapacidad. Entonces, ¿qué pasa? Que nos encontramos en los libros de texto un ocho por ciento de mujeres solo. Fíjate, ninguna filósofa aparece aquí en el plan de estudios de España en secundaria, en segundo de bachillerato. En Wikipedia. Hay un once por ciento de mujeres. Quienes trabajan como editoras te dirán que es más difícil introducir los datos en un perfil de una mujer que es referente que en un jugador de tercera regional de fútbol. Es más dramático, te cuestionan más. Ya puede ser Nuria Oliver, Nerea Luis, Pilar Manchón, eminencias de la inteligencia artificial, que te van a cuestionar.

Y es dramático. Tenemos que hackear estos estereotipos y también dar el reconocimiento que merecen a estas mujeres.

Perdona, tú no vas a un país donde hay hambruna, coges a un niño o a una niña y le dices: «Tienes que comer más». No, no, es que todo parte de la educación y de los estímulos y de lo que la sociedad espera de ti. ¿Qué cosas se espera que las mujeres hagamos? ¿Qué tareas? Cuidados, atención… ¿Y cómo tenemos que ser? Calladitas, educaditas. Y las mujeres que somos asertivas o que tenemos liderazgo siempre hemos oído: «Es que pareces un tío». O incluso cuando hemos asumido puestos de responsabilidad: «¿Pero tú serás capaz?». Perdona, yo voy a ser capaz de todo. O sea, ¿no? Y muchas más cosas que oímos y que, claro, van mermando. ¿Cómo yo me voy a presentar a liderar un equipo dentro de mi empresa si continuamente recibo estímulos? Entonces, primero hay que hackear esos estereotipos, hacer educación, sobre todo en este sentido, tanto a chicos como chicas. Y aquí hay una maravillosa canción que la hicieron dos colegios del Alto Pirineo, de Huesca, que no sé si la habéis escuchado, que es: «Fuerte, valiente, inteligente, no tienen masculino, no tienen femenino. Es cuestión de dos. Feliz, alegre, independiente. No tienen masculino, no tienen femenino. Es cuestión de dos». Empieza por la base, por la educación, y también por casa, por los valores que vemos. Luego dentro de las empresas. Hay algunos hombres que se piensan que les van a quitar ese centro de poder. O cuando hablamos de cuotas, por ejemplo: las mujeres que llegan muy alto en empresas han tenido que pasar una maratón X-Trial o como queráis llamarlo, han tenido que pasar muchas cosas y justificar continuamente qué están haciendo ahí. Entonces, hay que trabajar en ese sentido y hay que cumplir los planes de diversidad de forma real, de forma real, que no sea un feminismo «fake».

No, hay que hay que cumplir esos planes y dar los permisos de paternidad y la misma igualdad de oportunidades. Y empezaría por, en la empresa, dar formación, que todo el mundo fuera consciente de eso. Yo cuando doy formación, que impartimos en Mujeres Tech formación en empresas, muchas veces se acercan y me dicen: «Jo, tía, no lo había visto así, me has tocado». Claro, incluso me acuerdo yo en Woman Tech, que es un evento referente en Huesca, al que vino Chus Gutiérrez a presentar Rol & Rol. Pues vino un periodista y me dijo: «Tía, me he quedado en shock, estoy aún… Porque, claro, nunca había visto de forma tan clara lo que pasáis las mujeres». Pero esto es cuestión de dos, como dice la canción. Necesitamos, por un lado, a las mujeres darle esa autoestima. El «cree en ti». Yo cuando le digo a mi sobrina: «Venga, ¿qué eres?». «Guapa». «No, tú eres lista». Lista. Vale. ¿Y a él? «Llora». Cuando ves a alguien: «Llora, llora, no pasa nada». Decía Rojas-Marcos que las mujeres vivimos más porque hablamos más. Entonces, claro, en esto hay que trabajar de forma igualitaria y, como dice la gran Rosa Luxemburgo, tenemos que construir entre todas y todos una sociedad donde seamos socialmente iguales, humanamente diferentes y totalmente libres.

Es más fácil lanzar una inteligencia artificial al mercado que un juguete, por ejemplo. Según Daniel Kahneman, uno de los grandes premios Nobel de Economía, cuando tienes que tomar decisiones a la hora de, en este caso, entrenar a la máquina, vas a tomar esas decisiones en virtud de tu sistema de creencias, de tu intuición. Claro, pensemos que, si en esos equipos no hay personas de color, no hay personas negras, no hay personas asiáticas, no hay personas musulmanas, pues pasa lo que pasa. A GPT-3 lo denunciaron porque introducías un «input», un «prompt», que ponía: «Dos musulmanes entran…», «…en una iglesia y hacen de todo menos el bien». ¿Pasaría lo mismo si pusiéramos «Dos cristianas, dos personas cristianas…»? Y muchas soluciones. Joy Buolamwini, que es una activista de inteligencia artificial que denuncia… A ella le dieron una beca para hacer su doctorado en el MIT. ¿Cuál fue su sorpresa? Que llegó al reconocimiento facial y, como era negra, no la reconocía. Se puso una máscara blanca y ya la reconocía. Esto lo podéis ver en un documental maravilloso, que se llama «Coded Bias», sesgos codificados. Y os podría contar un montón de cosas. Claro, es que los equipos que desarrollan esa inteligencia artificial no son diversos, todos piensan lo mismo. Entonces, a la hora de programar no toman conciencia de la diversidad que hay en la sociedad. Entonces, ¿cómo se hackean esos sesgos? A la hora de desarrollar, en el momento inicial de desarrollo del producto, cuestionándote cosas: «Oye, ¿qué datos estoy empleando yo? ¿Están bien hackeados?». De hecho, hay soluciones de «open source», de código abierto, donde tú subes los datos y te dice si están sesgados.

«¿Por qué estás utilizando esta variable y no otra?». Y aquí llegamos a una cuestión muy importante que van a tener que trabajar las empresas, instituciones públicas, que utilizan algoritmos para tomar decisiones, que se llama XAI, «explainable artificial intelligence». O sea, tienes que explicar por qué, si estás utilizando un algoritmo para tomar decisiones que impactan en personas, ¿qué variables estás tomando? Porque bastaría, en este caso, por ejemplo, de los currículums, anonimizar las variables de identidad. «Algoritmo, no tengas en cuenta “mujer”… No lo tengas en cuenta». Y muchas soluciones que se podrían tener en esa etapa inicial de desarrollo de producto. Y aquí es necesaria otra vez la diversidad. Hay una herramienta que yo suelo recomendar, que es el Data Ethics Canvas, desarrollada por Tim Berners-Lee de Open Data Institute. El «model canvas» es un lienzo donde hay diferentes recuadros, donde diferentes perfiles intervienen en la creación del producto. Un cuadro, un cuadradito, sería «fuentes de datos», de dónde yo recojo los datos. ¿Qué tipo de datos? Datos relacionados con la identidad, datos de la geolocalización de las personas. ¿Dónde tienes alojados los datos? Privacidad. Ahí ya estarían las personas de Legal y empezaría a trabajar con personas de Regulación, con personas de Diseño, con personas de Marketing. ¿Qué pasa si la inteligencia artificial que yo he lanzado está sesgada? Luego puedo tener una crisis de reputación. Pues ya estarían esas personas. De forma cooperativa, estamos produciendo o intentando minimizar esos sesgos de la inteligencia artificial.

Pueden detectar a través de la humedad, los dispositivos, los sensores, que es el internet de las cosas. Puede decirme: «Oye, mira, ten cuidado, que puede aparecer tal plaga». Y, respecto al cambio climático, le he preguntado a mi socio, Paul Van Branteghem, que él es físico y que sabe mucho. Porque el clima es el sistema más caótico y el generador, fuente de datos… o sea, el volumen de datos mayor… La gente se piensa que son las redes sociales. No, es el clima. «Las redes sociales». No, es el clima, es muy caótico. Claro, por eso muchas veces consultamos… «Me ha dicho que iba a hacer sol, pero iba a llover y luego llueve. Y ahora no». Es que es muy complejo gestionar todo eso, pero esta herramienta es de unos canadienses, de un equipo canadiense, que es: tú le haces una foto a tu casa… Imagínate, idílico, con tu coche guay y, a través de una inteligencia artificial, te hace un escenario caótico con el impacto del clima: inundado… Todo para que tomemos conciencia del impacto de no cuidar nuestro clima.

Y pensemos también… Os he hablado un montón de las limitaciones que tienen a día de hoy estas herramientas, estas tecnologías. Atienden solo a una cosa específica, no tienen esa capacidad de la emoción, la empatía. Yo a un robot lo puede entrenar para que me diga… Que le diga yo con unas FAQ, con unas preguntas de respuestas fáciles. Pero no implica que tenga empatía, simplemente que ha sido entrenado y por esos patrones me va a decir… Si yo le digo: «Estoy triste». «Anda, Cristina, anímate, toma esta música que es la que a ti te da subidón». Ay, qué majo, qué empático es el sistema. No, es que me lo he programado yo. O sea, no es empático. Claro, abordamos temas… La inteligencia artificial… De hecho, un profesor de Stanford, Thorne, dice que habría que incluirla en el ámbito de las humanidades porque implica reflexión, implica el cuestionarnos a nosotros como personas e implica también hablar de esa reflexión de la conciencia, que es percibirse a uno mismo y percibir el entorno y cuestionarse cosas. Las máquinas no tienen eso. Las máquinas hemos dicho que tienen ceros y unos, y hacen cero coma cero, cero, cero, y no tienen esa parte cognitiva de la emoción, de la sensibilidad, de la piel. No tienen eso. Yo siempre pongo el ejemplo de mi sobrino: fuimos un día a una gran cadena de productos rápidos de hamburguesas y digo: «Ah, pues querrá ir al tótem, automático». Y dijo: «No, no, no, voy con Sebas, que me atiende superbién». Claro, aquí es donde nos va a representar el gran valor. Donde aportamos valor los humanos, en esa relación personal, en la empatía, en las emociones, en muchas cosas que las máquinas no tienen.

Entonces pensemos que… No nos dejemos agobiar por el miedo. Es que más miedo nos tienen que dar otras cosas. Es una herramienta. Yo pongo ejemplos. Por ejemplo, Ana Freire. Sabéis el gran problema que hay con la salud mental. De hecho, nuestros jóvenes se suicidan. Es la principal causa de muerte en adolescentes. Ana Freire, junto a un equipo diverso de personas especializadas en psiquiatría, lingüística, psicología e ingeniería, han entrenado una máquina para detectar conductas suicidas en Twitter y les mandan un mensaje de tal manera que han conseguido… Les mandan un mensaje como si fuera un anuncio. «¿Necesitas ser comprendida o comprendido?». Ahí juegan con el vínculo a través del lenguaje y han conseguido incrementar un sesenta por ciento de llamadas al Teléfono de la Esperanza. Y os podría enumerar un montón de inteligencias artificiales que resultan en un impacto positivo, pero eso nace de las personas, y somos las personas quienes tenemos la capacidad de generar este cambio y utilizar esta tecnología de forma maravillosa. Bueno, pues espero que, a través de esta conversación, este debate, estas preguntas, hayamos todos perdido el miedo a la inteligencia artificial y salgáis con ganas de utilizar esta increíble tecnología. Y también teniendo en cuenta la diversidad. La diversidad como algo enriquecedor para hacer cosas de alto impacto. Y pensad que esta tecnología sigue siendo muy tonta y nosotras, las personas, somos muy listas. Así que, como decía la gran Gloria Fuertes en su maravilloso poema «No tengo memoria»: «Estamos las personas condenadas a ser inteligentes a palo seco».